Er bestaan maar twee soorten computerbestanden. Computers worden heel blij van één bestandssoort, maar we gebruiken vooral het andere.

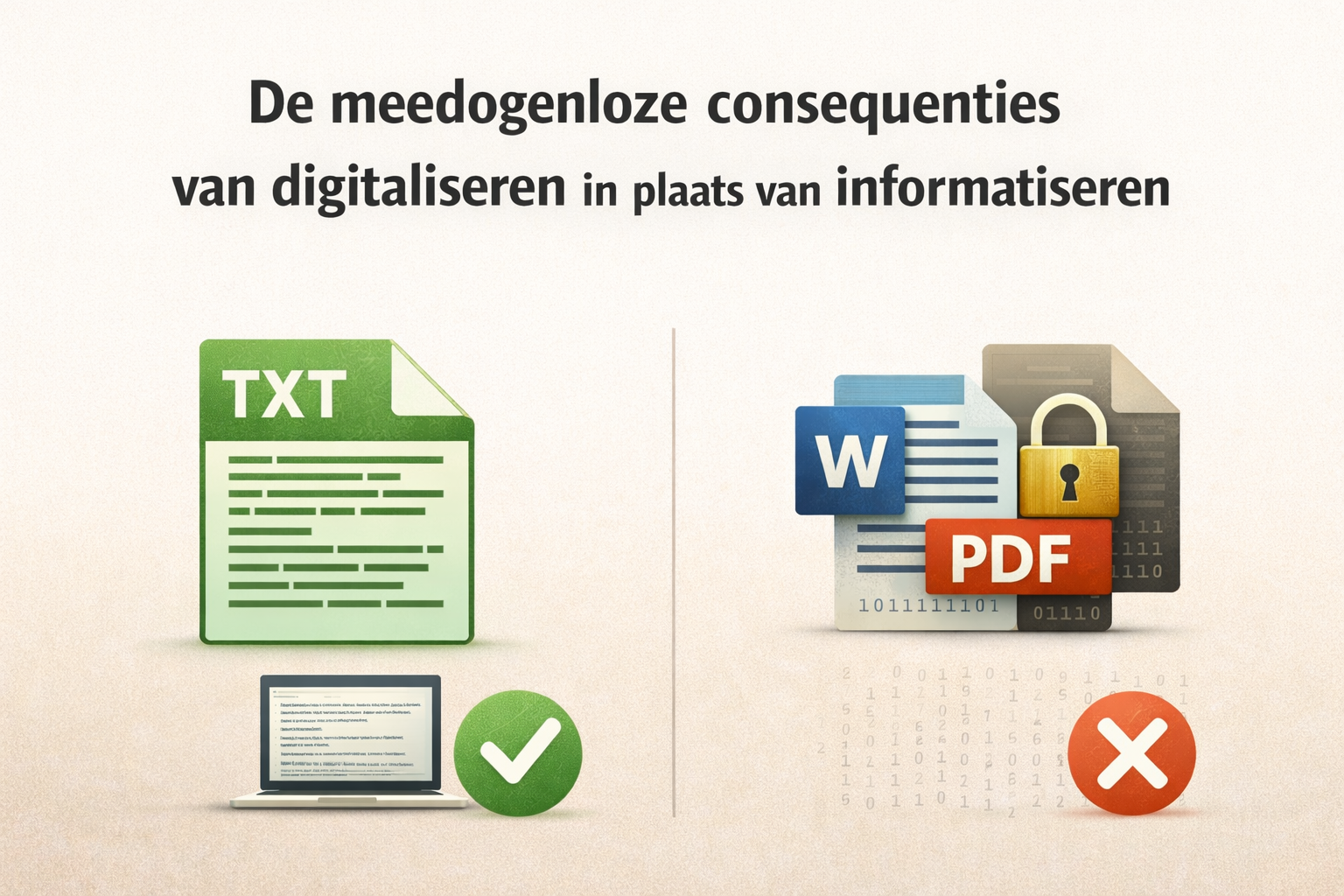

TL;DR Er bestaan maar twee soorten computerbestanden: tekstbestanden die een computer direct kan lezen en binaire bestanden waarvoor speciale software nodig is. Vrijwel alle documenten in organisaties worden opgeslagen in binaire formaten zoals Word en PDF, formaten die in essentie printerinstructies zijn. Dat is geen onschuldige gewoonte. We hebben dertig jaar lang gedigitaliseerd in plaats van geïnformatiseerd: papieren processen overgezet naar een scherm zonder de informatie los te maken van haar drager. Het gevolg is een keten van afhankelijkheden die miljarden kost aan ICT. Archieven worden ondoorzoekbaar en we bouwen energieverslindende AI-systemen om informatie te bevrijden uit formaten die nooit bedoeld waren om informatie in op te slaan. Het alternatief bestaat al en is simpel en goedkoop. De drempel is niet technisch maar organisatorisch.

Afgelopen week had ik met een aantal informatieprofessionals een verdiepend interview over informatieautonomie voor een vakblad. Arre Zuurmond, oud-rijkscommissaris informatiehuishouding, schoof ook aan. En gaandeweg het gesprek besefte ik me iets wezenlijks dat veel IT-ers, informatieprofessionals, bestuurders en beslissers over het hoofd zien: een gebrek aan basiskennis over de werking van een computer, over het bestandsformaat en over de consequenties van het verschil.

Toen die kwartjes eenmaal vielen in ons gesprek, sprak Arre uit: "We hebben ergens in de jaren tachtig de verkeerde afslag genomen." En nu zitten we met de ingrijpende, miljarden verslindende consequenties. En die werken extra door in een tijdperk waarin datasoevereiniteit en AI bepalende factoren zijn voor nieuwe (broodnodige) keuzes.

Al die duizenden bestanden die we in de loop der jaren verzameld hebben op ons werk en thuis op onze computers en telefoons en in de cloudomgeving, en al die documenten en foto's en spreadsheets en presentaties vallen uiteen in maar twee bestandsfamilies: tekstbestanden en binaire bestanden.

Wat is een tekstbestand eigenlijk?

Een tekstbestand is eigenlijk het basiselement op een computer. Het is een bestand dat bestaat uit letters, cijfers en leestekens, en als je het opent zie je gewoon tekst die je kunt lezen zonder dat je er een speciaal programma voor nodig hebt. De simpelste teksteditor op je computer kan het aan. Schrijf ik 'Dit is een zin' in een tekstbestand, dan staat er op de harde schijf letterlijk: Dit is een zin.

Wat allemaal tot de familie van tekstbestanden behoort, is veel breder dan de meeste gebruikers zich realiseren. Niet alleen het simpele .txt-bestand, maar ook markdown, HTML, CSV, JSON, XML en alle broncode waarin programmeurs software schrijven. Een .txt-bestand wordt door de computer op precies dezelfde manier opgeslagen als een .html-bestand, een .csv-bestand of een .json-bestand. Het verschil zit niet in hoe het bestand wordt opgeslagen maar in hoe de tekst erin is georganiseerd: in HTML staan er tags, in JSON accolades, in CSV komma's tussen de waarden. De extensie vertelt de computer welk programma het bestand moet openen. Maar op het niveau van de harde schijf is het allemaal hetzelfde: leesbare tekens.

Als je de motorkap van het internet optilt, zie je overal platte, leesbare tekst. HTML, CSS, de configuratiebestanden van servers: het hele internet draait op tekstbestanden.

Maar er is dus nóg een familie van bestandsformaten

Naast tekstbestanden zijn er ook binaire bestanden, en die werken heel anders. Ze bestaan uit patronen van nullen en enen die alleen betekenis krijgen als een speciaal programma ze op de juiste manier uitleest. Open je een binair bestand in een teksteditor, dan zie je onleesbare rommel van rare tekens en blokjes.

Foto's zijn binaire bestanden, en muziekbestanden en video's ook. Hier wordt het interessant: ook Word-documenten en PDF's zijn dus binaire bestanden. Er staat tekst in die je kunt lezen als je ze opent in Word of in een PDF-lezer. Maar het bestand zelf is niet leesbaar zonder die software. De betekenis zit verpakt in technische structuren die alleen het juiste programma kan ontcijferen.

Een Word-bestand (.docx) is eigenlijk een ingepakt ZIP-archief met daarin XML-bestanden, stylesheets en metadata. Als je een .docx-bestand hernoemt naar .zip en het uitpakt (probeer het maar eens), vind je een hele mappenstructuur met technische bestanden die samen je document vormen. Die XML is technisch gezien een tekstformaat, maar open zo'n bestand en je ziet geen leesbare notitie: je ziet honderden regels opmaakcode waar de eigenlijke woorden in verdrinken.

Een PDF is nog een stap verder verwijderd van leesbare tekst. PDF staat voor Portable Document Format. Het formaat is ontworpen om er op papier goed uit te zien. De tekst in een PDF zit vastgeplakt aan een layout. Soms is de volgorde van woorden in het bestand niet eens dezelfde als de volgorde die je op het scherm ziet. De computer weet niet wat een alinea is of wat een kop is en ook niet wat bij elkaar hoort. Hij weet alleen waar elk teken op de pagina moet staan, want PDF is in essentie een printerinstructie.

Het is goed om je te realiseren dat PDF niet één formaat is, ook dit is een kleine familie op zich. Er bestaan varianten die specifiek zijn ontworpen om de zwaktes van gewone PDF op te vangen. PDF/A sluit alles wat nodig is voor weergave in het bestand zelf in, zodat je niet meer afhankelijk bent van externe software. PDF/UA voegt structuurinformatie toe zodat een computer wél weet wat een kop is en wat een alinea is. Beide proberen PDF geschikt te maken voor langetermijnarchivering en toegankelijkheid.

Het Nationaal Archief schrijft PDF/A voor als leveringsformaat. Want al die varianten zijn pogingen om een binair formaat te repareren. PDF/A probeert het afhankelijkheidsprobleem op te lossen door alles in te sluiten. PDF/UA probeert het structuurprobleem op te lossen door achteraf tags toe te voegen. Het zijn ingenieuze pleisters, maar het blijven pleisters op een formaat dat niet ontworpen is om informatie toegankelijk te maken maar om informatie af te drukken.

Een gemiddeld beleidsdocument in PDF is vijf tot vijftien keer groter dan dezelfde tekst in een plat tekstformaat.[^1] Dat klinkt als een detail, tot je het vermenigvuldigt met de schaal van een overheid. Het Nationaal Archief bewaart op dit moment 1,2 petabyte aan digitale bestanden, vrijwel volledig in binaire formaten. Een blik op hun eigen voorkeursformatenlijst geeft te denken: PDF/A voor tekst, TIFF en JPEG voor afbeeldingen. Alleen de metadata eromheen is in XML, een tekstformaat. De beschrijving van wat er in de documenten staat is dus doorzoekbaar, maar de documenten zelf niet. Gezien de functie en rol van het Nationaal Archief is dit ronduit bizar als je de implicaties hiervan doorgrondt.

Het gros van die 1,2 petabyte zijn scans en foto's, die je niet zomaar tot tekst kunt reduceren. Maar voor al het born-digital materiaal dat als tekst begon en vervolgens in PDF werd gegoten, geldt: het overgrote deel van die opslagruimte gaat niet naar de inhoud maar naar de verpakking. Als die tekstuele informatie in tekstformaten was opgeslagen, kon je er vandaag doorheen zoeken zoals je zoekt in een e-mail, zonder speciale software en zonder AI die het bestand eerst moet ontcijferen. Maar de werkelijke kosten zitten elders. We bouwen op dit moment energieverslindende AI-systemen en OCR-software om binaire bestanden om te zetten naar tekst, puur om ze doorzoekbaar te maken. De duurste technologie die we hebben zetten we in voor een probleem dat goedkoop oplosbaar is met een ander opslagformaat.

Een kostbaar verschil met verstrekkende gevolgen

Nu denk je misschien: interessant, maar wat maakt het uit? Ik open mijn Word-bestand, ik zie mijn tekst, alles werkt toch? Vandaag wel. Maar de vraag is of dat over twintig jaar ook nog zo is. In directieteams lijkt niemand zich er druk om te maken. En dat is opmerkelijk, want diezelfde directies maken zich wel massaal druk over duurzaamheid, security en datasoevereiniteit, zonder door te hebben hoe een verkeerd opslagformaat voor informatie doorwerkt in al die grote thema's.

Een tekstbestand uit 1975 kun je vandaag nog openen en lezen, omdat de betekenis er gewoon in staat als leesbare tekens. Je hebt daar geen specifieke software of specifiek besturingssysteem voor nodig, en al helemaal geen bedrijf dat de sleutel beheert. Tekstbestanden zijn vrijwel onverwoestbaar.

Bij binaire bestanden is dat anders, want die zijn afhankelijk van software die ze kan lezen. En software heeft de neiging om te verdwijnen. Bedrijven gaan failliet, producten worden stopgezet. Wie nu nog een WordPerfect-bestand uit de jaren negentig probeert te openen, merkt dat de informatie er nog wel in zit maar dat niemand meer de sleutel heeft.

Dit is geen theoretisch vraagstuk, maar een urgent en uiterst actueel probleem. Archieven en bibliotheken over de hele wereld worstelen ermee, van de Koninklijke Bibliotheek tot het Nationaal Archief en tal van overheidsinstellingen. Ze beheren bergen digitale documenten waarvan niemand zeker weet of ze over dertig jaar nog leesbaar zijn, niet omdat de informatie verloren is gegaan maar omdat het formaat afhankelijk is van software die dan misschien niet meer bestaat.

Er zit nog een laag onder dit verhaal die het verschil nog fundamenteler maakt. Wat een computer doet als hij een tekstbestand leest is bijna banaal eenvoudig: hij leest bytes en interpreteert ze als tekens. Er zit niets tussenin, er is geen decoder nodig en geen onnodige vertaallaag. Bij een binair bestand moet er altijd een programma tussen staan dat precies weet hoe de bytes zijn gerangschikt. Zonder dat programma is het bestand onleesbare rommel, en dat programma kan verouderen of op een dag simpelweg niet meer bestaan.

Computers zijn dol op bits en bytes. Ze vinden het heerlijk. Ze kunnen er grote porties van op en slikken moeiteloos honderdduizend van die hapjes door in een paar seconden. Dat is omdat ze ervoor gemaakt zijn. Binaire formaten vragen iets heel anders van ze: uitpakken, decoderen, interpreteren, en hopen dat de software die dat doet nog werkt en nog klopt.

Dit geldt ook voor kunstmatige intelligentie. Alle grote AI-modellen zijn getraind op tekst, niet omdat dat een bewuste ontwerpkeuze was, maar omdat het een logisch gevolg is van hoe computers werken: tekst is wat een computer het snelst en het goedkoopst kan verwerken. De volledige trainingsdata van een taalmodel als GPT of Claude bestaat uit de tekstversies van boeken, artikelen, websites, broncode en documentatie, kortom alles wat ooit als leesbare tekens op internet heeft gestaan. Binaire bestanden zitten daar niet bij, tenzij iemand de moeite heeft genomen om de inhoud eerst naar tekst te converteren.

Geef een AI-systeem een markdown-bestand en het begrijpt direct wat erin staat. Het kan de tekst lezen en analyseren, samenvatten of vertalen, en er zonder moeite vragen over beantwoorden. Geef datzelfde systeem een PDF, Word of Powerpoint-bestand en het moet eerst worstelen met de presentatielaag die aan de informatie vastzit: de layout en de volgorde van tekstelementen, de hele verpakking die tussen de machine en de inhoud in staat. Soms lukt dat redelijk, maar vaak gaat er betekenis verloren. En hoe dan ook kost het extra rekenkracht, en daarmee stroom en koeling, om informatie te bereiken die in een tekstbestand direct beschikbaar zou zijn geweest.

Er is inmiddels een hele industrie ontstaan die PDF's omzet naar tekstformaten, puur zodat AI-systemen ermee kunnen werken. Bedrijven bouwen steeds geavanceerdere software om informatie uit binaire formaten te bevrijden en terug te vertalen naar iets dat een computer van nature begrijpt. De ironie daarvan is moeilijk te missen. Als we die informatie vanaf het begin in tekstformaat hadden opgeslagen, was die hele tussenstap overbodig geweest.

Ik ervaar dit zelf elke dag. De afgelopen maanden heb ik een persoonlijk informatiesysteem gebouwd, ThetaOS, dat al mijn data bevat in markdown en JSON. Alle informatie staat in de TXT-familie. Sinds ik dagelijks werk met tienduizenden markdown-bestanden valt me op hoe snel alles gaat, van zoeken en verbanden leggen tot het stellen van AI-vragen over mijn eigen informatie. Het werkt zonder tussenstap en zonder vertraging, en dat had ik niet eerder meegemaakt. Juist dat contrast was de aanleiding om me af te vragen waarom het in organisaties, die over veel meer IT, budget en menskracht beschikken dan ik, allemaal zo traag gaat. Het antwoord bleek steeds weer terug te voeren op hetzelfde punt: hun informatie zit opgesloten in formaten die een computer niet direct kan lezen.

Tegelijkertijd hoor ik om me heen voortdurend mensen klagen dat AI niet doet wat ze willen, dat het hallucineert of context verliest. En als ik dan vraag in welk formaat hun informatie staat, is het antwoord vrijwel altijd hetzelfde: Word-bestanden, PDF's en PowerPoints. Ze vragen AI om te lezen wat voor een computer niet goed leesbaar is zonder intensief rekenwerk.

Wat me vooral opvalt is niet het technische verschil maar wat het in de praktijk betekent. Zoektechnologie kan tegenwoordig razendsnel verbanden leggen in enorme hoeveelheden tekst, via technieken als inverted indexing, vector search en retrieval augmented generation. Op schaal van miljoenen documenten, maar ook op de schaal van mijn eigen laptop. Dat is geen toekomstmuziek; ik doe het elke dag. Alleen werkt het uitsluitend op tekst die als tekst beschikbaar is. Een Word-bestand moet eerst gedecomprimeerd, geparsed en geconverteerd worden voordat dezelfde zoekvraag überhaupt gesteld kan worden. En naarmate AI-modellen krachtiger worden, wordt die voorwaarde niet zachter maar harder: het formaat waarin we informatie opslaan bepaalt steeds scherper wat we ermee kunnen doen.

Ik denk niet dat de mensen die over informatiebeleid beslissen dit zien. Ze hoeven niet te weten hoe een inverted index werkt, maar het gevolg van hun formatkeuze reikt verder dan ze vermoeden. Een CIO die vandaag besluit alles in PDF op te slaan neemt in feite een beslissing over wat zijn organisatie over vijf jaar met AI kan doen, zonder dat te beseffen.

Waar ik mijn hoofd maar over blijf breken is dat ik als zelfstandige met een laptop beschik over zoek- en analysemogelijkheden waar grote organisaties met hun miljoenenbudgetten niet aan kunnen tippen. Dat komt niet doordat ik betere technologie heb. Het komt doordat mijn informatie in een formaat staat dat die technologie direct kan bereiken. Er gaat publiek geld naar systemen die organisaties in de praktijk eerder beperken dan versterken, terwijl de uitweg simpeler en goedkoper is dan wat ze nu hebben.

We namen een verkeerde afslag

Hier zit het grote misverstand dat ik in organisaties steeds weer tegenkom. Mensen kiezen voor Word en PDF omdat ze opmaak willen en niet beter weten. Ze willen vetgedrukte koppen en nette marges, iets dat er professioneel uitziet. En dat krijgen ze ook. Dat is geen toeval. Dertig jaar lang heeft software ons getraind om te denken dat schrijven betekent: opmaken. De interface van Word draait om lettertypen, marges en kleuren, niet om de structuur van een betoog. Wie daarin opgroeit, gaat vanzelf geloven dat een document zonder opmaak geen serieus document is.

Maar ze beseffen niet dat ze daarmee hun informatie opsluiten in een formaat dat bedoeld is om af te drukken. Word is in de kern een programma om documenten te maken die er op papier goed uitzien, en PDF is letterlijk een afdrukinstructie. Het zijn printerformaten, en wij slaan onze kennis, onze beleidsnotities en onze verslagen op in die printerformaten. We bewaren informatie in dozen die bedoeld zijn om naar de drukker te gaan.

Dat is alsof je al je recepten bewaart als foto's van het kookboek in plaats van als tekst die je kunt doorzoeken, aanpassen en combineren. Zodra je iets wilt doen met die informatie, zit je vast. Als je zo naar dit verhaal kijkt, is het onbegrijpelijk dat we dit niet anders hebben gedaan. Maar tegelijkertijd heel verklaarbaar.

Toen organisaties in de jaren negentig computers gingen gebruiken, kwamen ze uit een papieren wereld. De computer was een vervanging van de typemachine en de archiefkast. Word nam de rol van de typemachine over, en het PDF-bestand die van de kopieermachine. Alles was gericht op het eindproduct: een document dat je kon afdrukken, ondertekenen en archiveren in een map. Over wat er zou gebeuren als je die informatie later weer wilde terughalen of doorzoeken, dacht niemand na. De computer werd ingericht als een digitale drukpers, niet als een informatiesysteem. Wat we hebben gedaan is digitaliseren: papieren processen overzetten naar een scherm. Wat we hadden moeten doen is informatiseren: de informatie losmaken van haar drager en zo organiseren dat een computer er iets mee kan. Dat onderscheid lijkt subtiel, maar het verklaart waarom we dertig jaar later nog steeds worstelen met vindbaarheid, doorzoekbaarheid en duurzaamheid van onze eigen documenten.

Die keuze was destijds begrijpelijk. Maar het is wel de keuze die nu aan de basis ligt van vrijwel alles wat we lastig vinden aan informatiemanagement en IT. En dat wringt en knelt, zeker in een AI-tijdperk.

De ongekende prijs die we betalen door deze verkeerde keuze

Een binair formaat betekent dat een computer de inhoud niet direct kan lezen, dus heb je software nodig om die inhoud te ontsluiten. Die software kost licenties, onderhoud en specialisten, en ze veroudert, dus vroeg of laat moet je migreren. Ondertussen heb je zoeksystemen nodig bovenop die software, en classificatiesystemen om vast te stellen wat er in al die bestanden staat, en preserveringsprogramma's omdat je niet weet of het formaat over dertig jaar nog leesbaar is. Het is een keten van afhankelijkheden die allemaal teruggaat op één keuze.

Bij tekstformaten valt die hele keten weg. De computer leest de inhoud direct.

Een concreet voorbeeld. Een beleidsmedewerker schrijft een notitie van twee pagina's in Word. Dat document wordt opgeslagen in SharePoint, waar een indexeringsservice het binaire formaat moet ontleden om de inhoud doorzoekbaar te maken. Het wordt geëxporteerd als PDF voor publicatie, waarvoor conversiesoftware draait. Het wordt gearchiveerd in een documentmanagementsysteem dat metadata moet extraheren om het vindbaar te houden. Een classificatietool probeert automatisch vast te stellen waar het over gaat, maar kan de inhoud niet direct lezen en moet het formaat eerst ontcijferen. En over vijf jaar moet het worden gemigreerd naar een nieuw systeem, waarvoor opnieuw conversie nodig is.

Datzelfde document in markdown had geen van die tussenstappen nodig. De tekst is direct doorzoekbaar, direct te classificeren, direct te archiveren. De informatie is de informatie, zonder tussenlaag.

Kijk met die blik eens naar het systeemlandschap van een gemiddelde grote organisatie. Documentmanagementsystemen, archiefsystemen, zoekmachines, conversietools, classificatiesoftware, records management. Die systemen doen ook andere dingen, van versiebeheer en toegangscontrole tot compliance en samenwerking. Maar een aanzienlijk deel van hun technische complexiteit komt voort uit het feit dat de onderliggende bestanden niet direct leesbaar zijn. Zonder binaire formaten zou de technische stapel eronder een stuk dunner zijn en vooral veel minder kwetsbaar voor hacks.

We gebruiken de woorden 'informatie' en 'presentatie' door elkaar, maar ze zijn niet hetzelfde. Een beleidsnotitie bevat een analyse, een conclusie en een advies. Dat is de informatie. De opmaak, het lettertype, de marges en het logo in de koptekst zijn de presentatie. In de meeste organisatiedocumenten is de informatie het enige dat er werkelijk toe doet, en die informatie is vrijwel altijd tekst met structuur. De presentatielaag voegt daar zelden iets inhoudelijks aan toe, maar verdubbelt of vertienvoudigt wel de technische complexiteit van opslaan, doorzoeken en archiveren. En er zit een subtielere kostenpost in die koppeling: doordat formaat en opmaak onlosmakelijk aan elkaar vastzitten, zijn we gaan geloven dat een document zonder opmaak geen goed document is.

Die overtuiging zit inmiddels zo diep dat ze zelden wordt uitgesproken en bijna nooit wordt bevraagd. Een voor de hand liggend bezwaar is dat tekstformaten niet alles kunnen wat Word of PDF kan. Maar dat bezwaar is kleiner dan het lijkt. Digitale handtekeningen zijn niet afhankelijk van een specifiek bestandsformaat en werken ook op tekstbestanden. De technologie bestaat al decennia en wordt dagelijks gebruikt door miljoenen softwareontwikkelaars die hun code signen via Git. Voor tekstbestanden werkt het zelfs eleganter dan voor binaire formaten, omdat de handtekening als leesbare tekst in het bestand zelf kan worden opgenomen. Wat ontbreekt is niet de techniek maar een kant-en-klare workflow voor kantooromgevingen. Zwartlakken is bij een tekstbestand juist eenvoudiger en betrouwbaarder dan bij een PDF, waar onder de zwarte balk de originele tekst soms nog gewoon uitleesbaar is. En wie denkt dat een tekstbestand geen afbeeldingen kan bevatten: markdown kan verwijzen naar afbeeldingen, die dan als apart binair bestand naast de tekst staan. De informatie blijft leesbaar, de afbeelding blijft een afbeelding, en ze zijn niet onlosmakelijk aan elkaar vastgeplakt zoals in een Word-bestand. Er zijn documenten waarbij visuele presentatie functioneel is, zoals een bouwtekening of een jaarverslag met infographics. Maar dat is de uitzondering. Het overgrote deel van wat organisaties produceren aan verslagen, notities, handleidingen, notulen en werkinstructies is inhoudelijk tekst met koppen en alinea's. De vraag is waarom we de technische last van een printerformaat dragen voor informatie die helemaal niet gedrukt hoeft te worden.

Maar wij moeten samenwerken met tracked changes en opmerkingen in de kantlijn, hoor ik dan. En goedkeuringsworkflows. Dat klopt, maar het bezwaar overschat hoe vaak die functies daadwerkelijk worden gebruikt. Het gros van de documenten in een organisatie wordt geschreven door één persoon en nooit gezamenlijk bewerkt. En zelfs waar dat wel gebeurt, is de samenwerkfase kort in verhouding tot de rest van de levenscyclus. Een document wordt een paar weken bewerkt en daarna jaren bewaard, doorzocht en gearchiveerd. Voor die paar weken samenwerking belasten we het document voor de rest van zijn bestaan met de technische complexiteit van een binair formaat.

Er zijn zwaardere bezwaren die ik niet wil omzeilen. Hoe bewijs je dat een document niet is gewijzigd sinds het is vastgesteld? Hoe regel je dat alleen bepaalde mensen bepaalde passages mogen inzien? Hoe voldoe je aan de Baseline Informatiebeveiliging Overheid? Dat zijn reële vragen, maar het antwoord is steeds hetzelfde: niets daarvan is afhankelijk van het bestandsformaat. Toegangscontrole, audittrails en onweerlegbaarheid zijn functies van het systeem dat bestanden beheert, niet van het bestand zelf. Een Word-bestand op een afdelingsschijf bewijst niets over zijn eigen integriteit. Het is het documentmanagementsysteem dat de versiegeschiedenis bijhoudt, de audittrail die registreert wie wanneer wat heeft geopend, de toegangscontrole die bepaalt wie erbij kan. Niets daarvan verandert als je het Word-bestand vervangt door een tekstbestand. Wat wegvalt is niet de beveiliging maar de complexiteit die het bestandsformaat toevoegt aan de beveiliging.

Nu is dit niet de enige reden dat ICT-systemen complex zijn. Maar het is opvallend hoeveel van die ogenschijnlijk losse problemen terug te voeren zijn op dezelfde oorzaak. Beveiliging rond documenten is zo complex omdat je bestanden alleen als geheel kunt delen, inclusief metadata en wijzigingsgeschiedenis die je misschien niet wilde meesturen. Netwerken worden belast door bestanden die vaak vele malen groter zijn dan de informatie die erin zit. En governance is zo ingewikkeld omdat je niet automatisch kunt vaststellen wat er in een binair bestand staat.

Het bestandsformaat is de malariamug van onze informatiehuishouding. Het ziet er onschuldig uit en niemand wijst ernaar als oorzaak, want het lijkt te basaal om er een probleem van te maken. Maar de problemen die het veroorzaakt manifesteren zich overal verderop in de keten, als zoekproblemen, als migratiekosten, als security-incidenten en mislukte AI-projecten, en ze worden stuk voor stuk aangepakt met dure oplossingen zonder dat iemand terugkijkt naar waar het begon. Metadata-extractie, zoekinfrastructuur, formatmigratie: het wordt allemaal pas complex en duur op het moment dat de onderliggende bestanden niet direct leesbaar zijn.

De rekening is navenant. Neem één middelgrote gemeente met tachtigduizend inwoners. Die gemeente heeft een afdeling informatievoorziening waar een stuk of vijf mensen werken die het documentmanagementsysteem beheren. Met salariskosten, werkgeverslasten en kantoorruimte kost dat al gauw een half miljoen per jaar. Het DMS zelf, een systeem als Corsa of Decos, kost twee- tot vierhonderdduizend euro per jaar aan licenties en onderhoud, en daar komt de infrastructuur bij: servers, opslag, backup, koeling, stroom. Maar die vijf mensen op de IV-afdeling zijn alleen het zichtbare deel. Op de afdelingen zelf zitten functioneel beheerders die een kwart tot de helft van hun tijd kwijt zijn aan het systeem. Dan is er de archivaris die toeziet op de Archiefwet, er zijn juristen die Woo-verzoeken afhandelen, en een gemiddelde gemeente behandelt er tientallen per jaar, elk verzoek kost tientallen uren werk omdat documenten gezocht, beoordeeld, gelakt en samengesteld moeten worden. En elke zeven tot tien jaar komt daar een migratie overheen: het ene DMS wordt vervangen door het andere, voorafgegaan door een aanbestedingstraject van maanden met marktverkenningen en demo's en een programma van eisen. Zo'n migratie kost een gemeente van deze omvang anderhalf tot twee miljoen euro.

Niet al die kosten verdwijnen natuurlijk met een ander bestandsformaat. De archivaris bestaat vanwege de Archiefwet, niet vanwege PDF. De Woo-juristen bestaan vanwege de Woo. Maar de hoeveelheid tijd die ze kwijt zijn is wel degelijk formaatafhankelijk. Bij een Woo-verzoek gaat nu een groot deel van de tijd op aan het bij elkaar zoeken van de relevante documenten. Als die informatie direct doorzoekbaar is, krimpt dat zoekwerk van dagen naar minuten. De beoordeling zelf, het lakken en de samenstelling kosten nog steeds tijd, maar het proces als geheel wordt een fractie van wat het nu is. Er zijn 342 gemeenten in Nederland, en de grotere zitten op een veelvoud van deze bedragen. Streep de kosten weg die puur wettelijk zijn, de archivaris, de Woo-juristen zelf, en reken alleen de meerkosten die voortkomen uit de ondoorzoekbaarheid van het formaat: het extra zoekwerk, de migratiekosten, het functioneel beheer rond het DMS, de licenties. Dan kom je op ruwweg de helft, ergens tussen een half miljoen en een miljoen per gemeente. Neem het midden en vermenigvuldig met 342 gemeenten: dat is tweehonderd tot driehonderd miljoen per jaar. En dan heb je de twaalf provincies, de 21 waterschappen en de hele Rijksoverheid nog niet meegeteld.

Voor de Rijksoverheid worden de cijfers groter en tegelijk schimmiger. De gerapporteerde structurele IT-uitgaven bedroegen in 2019 bijna drie miljard, achttien procent meer dan het jaar ervoor, maar onderzoekers van Nyenrode constateerden in het Financieele Dagblad dat de werkelijke kosten "fors hoger" liggen dan wat aan de Tweede Kamer wordt gerapporteerd. Een belangrijk deel is niet eens terug te vinden in de financiële verslaglegging. Het Rijks ICT-dashboard erkent op zijn eigen website dat het de totale ICT-kosten nog niet in kaart kan brengen en noemt zijn eigen rapportagemodel een "groeimodel." Laurens Matthijssen, oud-ICT-specialist op het ministerie van Landbouw, verklaarde voor de Commissie Elias dat de overheid jaarlijks vijf miljard verspilt, met name doordat systemen te complex zijn gemaakt waardoor er te veel geld nodig is voor beheer en onderhoud. Jaren later, in een reactie op iBestuur, was hij nog scherper: bedrijfseconomische sturing ontbreekt totaal, schreef hij, en de kosten worden met name gemaakt door de interne ICT-bedrijven van de overheid, "machtige kolossen, waarop ieder bedrijfseconomisch toezicht ontbreekt."

Maar de ICT-begroting is nog maar het begin van de keten. De functioneel beheerders en informatiespecialisten staan niet op de ICT-begroting maar op de personeelsbegroting. De juristen die Woo-verzoeken afhandelen staan op de begroting van de juridische afdeling. De projectmanagers van migraties, de consultants die informatieplannen schrijven, de archivarissen die documenten beoordelen en vrijgeven: dat zijn organisatiekosten die bestaan omdat de onderliggende informatie niet direct leesbaar is. De Rijksoverheid gaf in 2024 3,67 miljard uit aan externe inhuur, en een deel daarvan gaat naar specialisten die bezig zijn met precies dit soort werk.

Dan zijn er de reparatiekosten die bovenop de structurele uitgaven komen. In 2021 maakte het kabinet 780 miljoen vrij voor Open op Orde, een programma om de informatiehuishouding van het Rijk te verbeteren. De diagnose was dat informatie "verstopt zit in afdelingsschijven, documentmanagementsystemen, samenwerkruimtes en e-mails" en dat het "niet eenvoudig" is om "de juiste informatie boven tafel te krijgen." Dat is niet de formulering van een criticus maar van de overheid zelf. Staatssecretaris Van Marum zei in november 2025 dat er jaarlijks minstens een miljard extra nodig is tot 2030. De Woo-implementatie kost gemeenten structureel 42 miljoen per jaar, provincies vijf miljoen, waterschappen bijna vier miljoen.

De Rapportage Grote ICT-activiteiten van het Rijk over 2024 maakt de omvang van het probleem tastbaar. Die rapportage telt 184 grote projecten met een initiële raming van gezamenlijk zo'n zes miljard euro. De gemiddelde kostenoverschrijding was 27 procent, wat neerkomt op 1,62 miljard meer dan begroot, het hoogste percentage sinds de meting begon. De gemiddelde doorlooptijd is opgelopen tot ruim vijf jaar. Van de 31 projecten die in 2024 werden afgerond waren er slechts acht op tijd klaar. Structureel is er te weinig geld en te weinig capaciteit om de systemen die de overheid draaiende houden daadwerkelijk te vernieuwen, waardoor het overgrote deel van de beschikbare capaciteit opgaat aan het in de lucht houden van wat er al staat. Bij de Nationale Politie gaat zeventig procent van de ICT-capaciteit naar regulier beheer en slechts dertig procent naar vernieuwing.

Achter die gemiddelden zitten verhalen die je niet zou geloven als ze niet gedocumenteerd waren. De Belastingdienst draait zo'n negenhonderd systemen in dertig programmeertalen. De IT-organisatie telt 4.500 medewerkers, en daar bovenop is een inhuurraamovereenkomst afgesloten van ruim één miljard euro voor de komende vier jaar. Toch constateert de Algemene Rekenkamer dat de hoognodige vernieuwing van de systemen waarmee 182,6 miljard euro aan belastingen wordt geïnd opnieuw is vertraagd. De verouderde Cool:Gen-software die de aanslagen verwerkt zou eind 2026 zijn uitgefaseerd, maar dat schuift steeds verder op, en pas vanaf 2029 is er weer enige ruimte voor nieuwe plannen. Het CBR zag de kosten van een ICT-project oplopen van 7 naar ruim 34 miljoen euro en werkte intussen door met Windows XP en een Oracle 9-database waar een miljoen medische dossiers op stonden opgeslagen. Die kosten werden jarenlang verborgen gehouden voor de Tweede Kamer.

En dat zijn niet de uitzonderingen. Bij Defensie lopen twee programma's die samen meer dan zes miljard vertegenwoordigen. Het UWV kent een twintigjarige geschiedenis van mislukte ICT-vernieuwing, met kernsystemen op een platform waarvan de ondersteuning afloopt. De IND besteedde 166,6 miljoen aan een systeem dat op 68 miljoen was begroot. Bij de Nationale Politie gaat zeventig procent van de ICT-capaciteit naar regulier beheer en is driehonderd miljoen nodig om de datahuishouding op orde te brengen.

De invoering van de Omgevingswet illustreert hoe diep het reikt. Het Digitaal Stelsel Omgevingswet heeft tot nu toe 200 miljoen euro gekost aan ontwikkeling. De totale invoeringskosten worden geraamd op drie miljard euro tot 2032, waarvan driekwart bij gemeenten terechtkomt. Twee op de drie gemeenten wijkt uit naar een noodoplossing omdat de nieuwe standaard technisch te problematisch is. De terugverdientijd wordt geschat op 28 jaar. Achtentwintig jaar.

En dit is nog maar wat je ziet als je kijkt. Agentschappen als Rijkswaterstaat, DUO en het KNMI, ZBO's als de SVB, en tientallen andere uitvoeringsorganisaties hebben hun eigen vernieuwingsprojecten die lang niet allemaal in die Rapportage verschijnen. Rijkswaterstaat zag de apparaatgebonden ICT-kosten in 2024 met 14,4 miljoen stijgen boven de begroting. Bij DUO is het applicatielandschap het resultaat van bijna 45 jaar digitaliseren. Dienst Toeslagen en Douane zijn voor hun ICT volledig afhankelijk van de Belastingdienst, die zelf al tegen zijn capaciteitsgrenzen aanloopt. Vrijwel geen enkel ministerie voldoet op dit moment aan de Archiefwet als het gaat om e-mailarchivering.

Dan is er het productiviteitsverlies dat op geen enkele begroting staat maar dat mogelijk de grootste post is van allemaal. Onderzoek van IDC becijfert dat kenniswerkers gemiddeld tweeënhalf uur per dag kwijt zijn aan het zoeken naar informatie. McKinsey komt op bijna twee uur. Een onderzoek van Lucid Software dat in 2025 op Frankwatching verscheen rekende het om naar Nederlandse verhoudingen: 520 verloren uren per kenniswerker per jaar, ruim twaalfduizend euro per persoon. De overheid heeft ruwweg een miljoen ambtenaren. Zelfs als je aanneemt dat maar de helft daarvan regelmatig naar documenten zoekt en dat het verlies geen tweeënhalf uur maar één uur per dag is, kom je op zo'n drie miljard euro per jaar aan arbeidstijd die opgaat aan het zoeken naar informatie die niet vindbaar is.

Nu weet ik niet precies welk deel daarvan verdwijnt met een ander bestandsformaat. Mensen zoeken ook naar e-mails, naar chatberichten, naar informatie die in iemands hoofd zit. Maar een groot deel van het zoekprobleem komt niet voort uit slordigheid maar uit ondoorzoekbaarheid: bestanden waarvan je weet waar ze staan maar waar je niet doorheen kunt zoeken omdat het formaat een muur optrekt tussen jou en de inhoud.

Nu is het makkelijk om elk project afzonderlijk te verklaren met andere factoren: scope creep bij GrIT, politieke druk bij de Omgevingswet, verwaarlozing bij het CBR. Maar het bestandsformaat is de constante in de vergelijking. Het is wat elk migratieproject tot een conversieproject maakt, en wat elke zoekoplossing een vertaallaag geeft, en wat elke archiveringsvraag tot een preserveringsvraagstuk maakt. Dat is geen bijdragende factor. Het is de generatieve oorzaak: niet het bestandsformaat heeft GrIT laten mislukken, maar het bestandsformaat genereert de complexiteit waarbinnen projecten als GrIT mislukken. De Commissie Elias heeft de verspilling gedocumenteerd, de Algemene Rekenkamer schrijft er jaarlijks over, en het project Open op Orde is gebouwd op de diagnose dat informatie opgesloten zit. Ze beschrijven allemaal de symptomen. Wat niemand hardop uitspreekt is dat die symptomen een gemeenschappelijke oorsprong hebben, en dat die oorsprong zo basaal is dat hij onzichtbaar is geworden.

Wie de volledige keten overziet, de directe ICT-uitgaven, de personeelskosten die eraan vastzitten, de incidentele reparatieprogramma's en het productiviteitsverlies, komt op een bedrag in de orde van grootte van vijf tot tien miljard euro per jaar. Het verschil tussen die onder- en bovengrens hangt af van hoeveel van het productiviteitsverlies je meetelt, en daar valt over te twisten. Ik formuleer het bewust als bandbreedte, want de overheid weet zelf niet precies hoeveel het is. Het CBS erkende bij de Commissie Elias dat de werkelijke ICT-uitgaven "beslist veel meer" waren dan gerapporteerd. Op de vraag waarom dat niet openbaar werd gemaakt, luidde het antwoord dat het bedrag "politiek gevoelig" lag.

Dan zijn er nog de veiligheidrisico's. Elk systeem dat we om binaire bestanden heen bouwen, vergroot ook het aanvalsoppervlak van een organisatie. SharePoint, documentmanagementsystemen, conversietools en PDF-readers zijn allemaal complexe softwaresystemen met kwetsbaarheden die actief worden misbruikt. PDF laat toe om JavaScript en uitvoerbare bestanden in te sluiten. Een tekstbestand biedt die mogelijkheid niet: het formaat zelf kent geen mechanisme om code uit te voeren of bestanden in te bedden. Dat maakt het aanvalsoppervlak van een fundamenteel andere orde. Kwetsbaarheden in tekstbestanden bestaan wel, maar ze zitten in de software die het bestand opent, niet in het formaat. Hoe simpeler het formaat, hoe kleiner het oppervlak. De keuze voor binaire formaten is niet alleen een kostenpost en een duurzaamheidsprobleem maar ook een structureel veiligheidsrisico.

De culturele dimensie en obstakels

Allemaal leuk en aardig zo'n uitgebreide analyse naar hoe dingen nou precies zitten. En het is zeker niet uit te sluiten dat ik hier niet alleen meer dan een punt heb, maar gewoon gelijk. Maar tussen gelijk hebben en gelijk krijgen zit een wereld van verschil. In ons boek Easycratie beschreven we hoe organisaties vasthouden aan hiërarchische structuren terwijl de wereld om hen heen allang als netwerk functioneert. In de klassieker Nooit Af ging het over de drang om dingen af te maken in een werkelijkheid die sneller verandert dan je kunt bijhouden. Beide keren zagen we hetzelfde patroon: mensen begrepen het argument en waren het er vaak zelfs mee eens, maar gingen de maandag erna gewoon over tot de orde van de dag en mee in de maalstroom der dingen.

Mark Vletter van Voys, een van de succesvolste techbedrijven van Nederland, verwoordde het haarscherp: een grote organisatie anno 2026 is een informatieorganisatie. Een gegeven dat maar weinigen zich ten diepste realiseren. En als dat klopt, dan heeft de manier waarop die organisatie haar informatie opslaat consequenties die veel verder reiken dan IT alleen.

Ik realiseer me terdege dat ik technologiefilosoof ben en geen veranderkundige, al word ik vaak genoeg op dat thema uitgenodigd voor lezingen. Er zit onmiskenbaar een grote gedrags- en cultuurdimensie aan dit vraagstuk, maar daarin ben ik geen expert. Wat ik wel kan is beschrijven wat ik waarneem.

Toen ik dit onderwerp vorig jaar op LinkedIn plaatste, werd het mijn meest gedeelde post ooit. Wat me achteraf het meest trof was niet de instemming maar de aard van de kritiek. Vrijwel alle tegenargumenten gingen over processen, over samenwerken, over gebruiksgemak. Over wat mensen gewend zijn. Niemand reageerde op het technische punt zelf. Het verschil tussen twee bestandsfamilies en wat dat betekent werd onmiddellijk terugvertaald naar een discussie die mensen al kenden. Ik denk dat het voor een deel komt doordat vrijwel niemand iets basaals weet over informatie, over kilobytes, over hoe computers eigenlijk werken. Wat ik wonderlijk vind gezien het feit dat we de hele dag die apparaten bedienen die we dus nauwelijks begrijpen en doorgronden.

Collega-auteur en spreker George Parker schreef ooit over de hiërarchie van meningen: het verschil tussen aannames, meningen, overtuigingen en paradigma's. Een aanname kun je bijstellen met nieuwe feiten. Een mening verschuift door gesprek. Maar een paradigma is het kader waarbinnen je denkt zonder dat je het opmerkt, zoals je je eigen bril niet ziet.

De meeste mensen hebben bovendien helemaal geen keus. Hun werkgever heeft besloten dat Word de manier is waarop je informatie verwerkt, en daarmee is de discussie gesloten voordat die begonnen is.

Wat ik waarneem bij mensen die dit argument horen is geen weerstand, want weerstand veronderstelt dat iemand het punt ziet en er bewust tegen ingaat. Dit is iets anders. Mensen begrijpen het, soms zelfs onmiddellijk, maar dan stokt het omdat de implicaties te groot zijn. Als het bestandsformaat inderdaad aan de basis ligt van zoveel van wat er misloopt, dan klopt er iets fundamenteels niet aan hoe ze de afgelopen dertig jaar hun werk hebben ingericht, en ik denk dat de meeste mensen dat besef niet aankunnen. Je kunt het mensen natuurlijk moeilijk kwalijk nemen. Dat neemt niet weg dat we in het huidige discours over datasoevereiniteit, securityrisico's en de opkomst van AI niet om dit soort gesprekken heen kunnen.

De oplossing is pijnlijk eenvoudig

Het alternatief is niet dat iedereen moet leren programmeren, maar dat we onze informatie opslaan in formaten die zowel voor mensen als voor machines leesbaar zijn en die structuur bieden zonder de informatie op te sluiten.

Markdown is daar het meest toegankelijke voorbeeld van. Het is een tekstformaat waarin je met simpele tekens structuur aanbrengt: koppen, opsommingen, nadruk. Het bestand blijft leesbaar als platte tekst, ook in de simpelste teksteditor, maar het bevat genoeg structuur om er een opgemaakte pagina van te maken als je dat wilt. Voor gestructureerde data zijn er JSON en XML, voor tabeldata CSV. Allemaal leden van dezelfde TXT-familie.

Goede kans dat mensen zullen tegenwerpen: maar hoe zit het met complexe tabellen, formulieren, bestemmingsplannen? Maar hoeveel van die documenten staan er eigenlijk in de gemiddelde documentenmap van een afdeling? De meeste memo's, notulen en notities bevatten niets anders dan tekst met koppen en alinea's. Loop zelf maar eens door die map en tel. De uitkomst zal je verbazen. Markdown is niet voor alles geschikt, en dat klopt, het kent bovendien verschillende varianten en er is nog geen volledig bindende standaard. Maar zelfs de meest exotische markdown-variant is over dertig jaar nog leesbaar als platte tekst. Bij binaire formaten is die garantie er niet. De fallback van markdown is leesbaarheid, de fallback van een binair formaat is onleesbaarheid.

De Britse overheid laat zien hoe zo'n verschuiving eruitziet in de praktijk. Twintig jaar geleden publiceerde de overheid alles in PDF. Nu produceren meer dan tweeduizend ambtenaren dagelijks content in Govspeak, een eigen markdown-variant, via een publicatiesysteem dat workflows, versies en metadata beheert als gestructureerde tekst. De publicatiekant is volledig omgezet, de werkvloer nog niet, daar wordt intern nog veel in Word voorbereid. Maar het feit dat het publicatieproces van een hele overheid draait op platte tekst, is het bewijs dat het werkt.

Er is nog een groter bewijs. Toen OpenAI, Anthropic, Google en Meta hun AI-systemen bouwden, kozen ze allemaal markdown als outputformaat. Niet na overleg, niet na een standaardisatietraject. Onafhankelijk van elkaar, omdat het de voor de hand liggende keuze is als je informatie wilt genereren die direct leesbaar is voor een mens, direct verwerkbaar door een machine, en direct om te zetten naar elk ander formaat. Honderden miljoenen mensen werken nu dagelijks met markdown zonder dat ze het weten, elke keer dat iemand een antwoord krijgt van ChatGPT of Claude is dat markdown. De slimste technologiebedrijven ter wereld mochten vanaf nul kiezen hoe ze informatie uitwisselen met mensen, en geen van hen koos voor Word of PDF.

Er is bovendien een verschuiving gaande die zich grotendeels buiten het zicht van beleidsmakers voltrekt. Wereldwijd slaan miljoenen mensen dagelijks hun kennis en informatie op in tools als Obsidian en Notion. Obsidian is volledig gebouwd op markdown. Maar het gaat verder dan dat: markdown zit inmiddels in Slack, in WhatsApp, in Discord, in GitHub. Die verschuiving is met name zichtbaar bij jongere professionals en studenten, die markdown als vanzelfsprekend meenemen en Word als log en traag ervaren. Zoals iA het treffend verwoordt in hun analyse 'Markdown and the Slow Fade of the Formatting Fetish': mensen gebruiken Word niet omdat het goed werkt, maar omdat het ze wordt opgelegd op school en op het werk. Zodra die dwang wegvalt, kiezen ze voor iets anders. De ironie is dat in steeds meer grote overheidsorganisaties individuele medewerkers al lang ontdekt hebben dat dit beter werkt, maar er officieel niet mee mogen werken van hun baas.

De technische drempel is verrassend laag. Een organisatie kan besluiten dat vanaf morgen alle nieuwe notities, verslagen en handleidingen in markdown worden geschreven. De tools bestaan al en veel ervan zijn gratis. Alles wat gepubliceerd wordt kan naast de PDF ook als markdown of HTML beschikbaar worden gesteld. En je kunt beginnen met het toevoegen van gestructureerde metadata in tekstformaten aan bestaande binaire bestanden, zodat die in ieder geval vindbaar worden.

Dat is geen pleidooi om morgen alle bestaande bestanden om te zetten. Dat zou een migratieproject van jaren zijn met flink wat kosten en risico's. Maar het is wel een pleidooi om vandaag te stoppen met het vergroten van het probleem, en de redenen om dat te doen zijn acuut.

Wat je nu betaalt aan licenties, conversietools en consultants om binaire bestanden doorzoekbaar en beheersbaar te houden, is een hoop geld dat je kunt besparen. De AI-projecten die niet opleveren wat je hoopte, leveren in veel gevallen niet omdat de informatie opgesloten zit in formaten die een computer niet direct kan lezen. En medewerkers die dagelijks tijd verliezen aan het zoeken naar documenten die ze niet kunnen vinden, worden productiever en slagvaardiger zodra die informatie direct doorzoekbaar is. Ondertussen groeit met elk systeem dat je om binaire bestanden heen bouwt ook het aanvalsoppervlak van de organisatie en daarmee de kwetsbaarheid voor hacks en gegevenslekken.

Een tekstbestand is over dertig jaar nog leesbaar, een binair formaat misschien niet. Maar je hoeft niet dertig jaar vooruit te kijken om te zien dat de huidige keuze duur is.

En de risico's lopen niet gelijk op. Als je nieuwe informatie opslaat in tekstformaat en dat blijkt niet te werken, kun je die bestanden converteren naar elk ander formaat. Het is platte tekst, Je zit nergens aan vast. Blijf je bij binaire formaten en die blijken over twintig jaar niet meer houdbaar, dan zit je met een berg bestanden die je alleen met gespecialiseerde software kunt ontcijferen. Als die software dan nog bestaat.

De documentformaten die we dagelijks gebruiken koppelen informatie onlosmakelijk aan haar presentatie. Dat dwingt ons om de verpakking overal mee naartoe te slepen waar we de inhoud willen gebruiken. Tekstformaten ontkoppelen die twee. De informatie staat op zichzelf, en de presentatie is een keuze die je er later overheen legt, of niet. Dat verschil klinkt technisch, maar het raakt aan alles: aan vindbaarheid en duurzaamheid, aan kosten en veiligheid, en uiteindelijk aan de vraag of jij de baas bent over je eigen informatie, of dat een softwarebedrijf dat voor je bepaalt.

Er is maar één manier om erachter te komen hoe dit in de praktijk werkt, en dat is het doen. Niet met een drastische koerswijziging maar met een langdurig iteratief proces waarin je stap voor stap ontdekt wat de implicaties zijn en hoe je ze kunt ondervangen, vanuit een heel concreet, praktisch handelingsperspectief. Dat is precies wat we doen met de Pilot Informatieautonomie, waarin een groeiend aantal overheidsorganisaties samen met een groep ervaringsdeskundigen onderzoekt hoe informatie er anders uit kan zien.

Bronnen

Nationaal Archief en voorkeursformaten

- Nationaal Archief, "Het Nationaal Archief voor een open en transparante overheid". Bron voor de 1,2 petabyte aan digitale bestanden en de organisatiebeschrijving.

- Nationaal Archief, "Lijst voorkeursformaten". PDF/A als voorkeursformaat voor tekst, TIFF en PNG voor afbeeldingen.

- Nationaal Archief, "Norm Voorkeursformaten". Achtergrond bij de selectiecriteria en het onderscheid tussen voorkeursformaten en acceptabele formaten.

- Nationaal Archief, "Voorkeursformaten Overheid". Uitleg over bestandsformaten en de Archiefregeling 2009.

Britse overheid en GOV.UK

- GOV.UK, Govspeak guide. Beschrijving van Govspeak als markdown-variant voor overheidspublicaties.

- GitHub, alphagov/govspeak. Technische documentatie van de Govspeak-library.

- Inside GOV.UK, "Moving our most-used publishing tool to the GOV.UK design system", 8 februari 2024. Bron voor het getal "more than 2,000 publishers across government."

- Technology in Government, "Introducing the GOV.UK publishing platform in detail", 8 juli 2016. Architectuurbeschrijving van het publicatieplatform.

iA en markdown-adoptie

- iA, "Markdown and the Slow Fade of the Formatting Fetish". Analyse van de verschuiving van propriëtaire formaten naar markdown.

ICT-kosten Rijksoverheid: structureel

- Rijksoverheid, Rapportage Grote ICT-activiteiten Rijksoverheid 2024. Bron voor 184 projecten, zes miljard initiële raming, 27 procent gemiddelde kostenoverschrijding, 1,62 miljard overschrijding, gemiddelde doorlooptijd vijf jaar, 8 van 31 projecten op tijd.

- Nyenrode/Financieele Dagblad, L. Hilhorst & L. Sneller, onderzoek naar werkelijke ICT-kosten overheid. Bron voor de constatering dat werkelijke kosten "fors hoger" liggen dan gerapporteerd.

- Rijks ICT-dashboard, dashboard.rijksictdashboard.nl. Bron voor de zelfkwalificatie als "groeimodel" en de erkenning dat totale ICT-kosten niet in kaart zijn gebracht.

- Laurens Matthijssen, verklaring bij Commissie Elias (Parlementair onderzoek ICT-projecten bij de overheid, 2014). Bron voor de schatting van vijf miljard aan verspilling.

- Laurens Matthijssen, reactie op iBestuur. Bron voor het citaat over "machtige kolossen, waarop ieder bedrijfseconomisch toezicht ontbreekt."

- CBS, verklaring bij Commissie Elias. Bron voor de erkenning dat werkelijke ICT-uitgaven "beslist veel meer" waren dan gerapporteerd en dat het bedrag "politiek gevoelig" lag.

ICT-kosten Rijksoverheid: reparatie en vernieuwing

- Rijksoverheid, Programma Open op Orde, 2021. 780 miljoen vrijgemaakt voor verbetering informatiehuishouding. Bron voor de diagnose dat informatie "verstopt zit in afdelingsschijven, documentmanagementsystemen, samenwerkruimtes en e-mails."

- Staatssecretaris E. van Marum, Kamerbrief/NDS-raming, november 2025. Bron voor "jaarlijks minimaal 1 miljard euro extra nodig." Zie ook: Digitale Overheid, "Tijd voor digitale versnelling: extra investeringen noodzakelijk", 10 december 2025; iBestuur, "Geschatte kosten NDS: bijna 1 miljard euro", 18 november 2025.

- VNG/IPO/UvW, Woo-implementatiekosten. Bron voor gemeenten structureel 42 miljoen, provincies 5 miljoen, waterschappen bijna 4 miljoen per jaar.

Specifieke ICT-projecten

- Algemene Rekenkamer, diverse rapporten Belastingdienst. Bron voor 900 systemen, 30 programmeertalen, 4.500 IT-medewerkers, 430 miljoen ICT-budget, inhuurraamovereenkomst ruim 1 miljard, vertraging Cool:Gen-vervanging, en de constatering dat vernieuwing van systemen voor 182,6 miljard aan belastinginning opnieuw is vertraagd. Zie ook: Kamerbrief Beheerst Vernieuwen, Binnenlands Bestuur over COBOL bij de Belastingdienst en Consultancy.nl over ICT-raamovereenkomst.

- Autoriteit Persoonsgegevens, rapport over RAM-opvolgers, juli 2025. Eis tot versnelde vervanging van twee systemen Belastingdienst vanwege privacyproblemen. Zie ook: Computable.

- Ministerie van Defensie, Kamerbrief GrIT-programma. Begroot 3,2 miljard, 362 miljoen kostenstijging, drie jaar vertraging. Zie ook: Computable.

- Ministerie van Defensie, behoeftestelling programma Foxtrot. Tot 2,5 miljard.

- EY-rapport Nationale Politie, Eindrapportage doorlichting informatievoorziening. Financiën rondom ICT niet onder controle. Zie ook: NOS en Computable.

- Politievakbond (Nine Kooiman), geciteerd in Consultancy.nl. Bron voor 300 miljoen nodig voor datahuishouding en 80 procent externe inhuur cyberkrachten.

- Nationale Politie, jaarverslag/capaciteitsverdeling. Zeventig procent ICT-capaciteit naar regulier beheer.

- UWV, diverse bronnen. OpenVMS-platform, aflopen ondersteuning. 8Vance-project: contract 65 miljoen. Zie: Computable, "Het (nep?) mega-ict-project van UWV WERKbedrijf", december 2024.

- IND, INDiGO-evaluatie. Oorspronkelijke raming 68 miljoen, uiteindelijk 166,6 miljoen totaal (95,5 miljoen directe projectkosten, 22,5 miljoen doorontwikkeling, 28,6 miljoen beheer/ondersteuning, 20 miljoen INDIS in lucht houden). Zie: Computable en Binnenlands Bestuur.

- CBR, Zembla-onthulling april 2019. ICT-project van 7 naar 34 miljoen, kosten verborgen voor Tweede Kamer, Windows XP, Oracle 9-database, 1 miljoen medische dossiers. Zie: Computable en ICT Magazine.

- Omgevingswet/DSO. Gemeente.nu, "Extra geld moet invoering Omgevingswet en DSO redden": 200 miljoen ontwikkelingskosten. Gemeente.nu, "Invoeringskosten Omgevingswet lopen in de miljarden": totale invoeringskosten geraamd op 3 miljard tot 2032, driekwart bij gemeenten. Binnenlands Bestuur, "Omgevingswet valt miljard duurder uit": van 1,6 naar 2,7 miljard. Binnenlands Bestuur, "Invoering Omgevingswet na 19 jaar terugverdiend": terugverdientijd 28 jaar.

- Rijkswaterstaat. Rijksjaarverslag 2024, agentschap Rijkswaterstaat: apparaatgebonden ICT-kosten 14,4 miljoen boven begroting (licenties, uitbestede dienstverlening, technische infrastructuur). ICT-strategie 2025-2030. Verkeersmanagementproject (CHARM): vijf jaar vertraging, 75 procent kostenoverschrijding, Accountant.nl/AG Connect-analyse.

- DUO. Stand van de Uitvoering OCW en Kamerstuk 25268 nr. 176: applicatielandschap resultaat van 45 jaar digitaliseren, 440 applicaties voor ruim 40 wettelijke taken, verouderde software, schaarse kennis.

- Rijksoverheid, externe inhuur 2024: 3,67 miljard. Jaarrapportage Bedrijfsvoering Rijk.

Gemeentelijke kosten

- VNG, gemeentelijke informatievoorziening. Achtergrond voor DMS-kosten (Corsa, Decos), functioneel beheer, migraties.

- Aantal gemeenten in Nederland: 342 (per 1 januari 2025).

- Woo-verzoeken: gemiddeld tientallen per middelgrote gemeente per jaar. Gebaseerd op VNG-cijfers en Open State Foundation-data.

Productiviteitsverlies

- IDC, "The High Cost of Not Finding Information", IDC White Paper, 2001. Bron voor de schatting van 2,5 uur per dag. NB: Dit is een veelgeciteerde maar verouderde schatting; latere IDC-onderzoeken (2012) komen op 8,8 uur per week (circa 1,76 uur per dag).

- McKinsey Global Institute, "The Social Economy: Unlocking value and productivity through social technologies", 2012. Bron voor 1,8 uur per dag zoeken en verzamelen van informatie.

- Lucid Software, Acceleration Equation Survey, gepubliceerd op Frankwatching, mei 2025. Bron voor 520 verloren uren per kenniswerker per jaar onder 265 Nederlandse respondenten. Het bedrag van ruim twaalfduizend euro per persoon is een eigen berekening op basis van gemiddeld uurloon.

Overig

- Commissie Elias, Parlementair onderzoek naar ICT-projecten bij de overheid, Tweede Kamer, 2014. Bron voor diverse citaten en bevindingen.

- George Parker, hiërarchie van meningen/overtuigingen. Spreker en auteur.

- Arre Zuurmond, oud-rijkscommissaris informatiehuishouding. Geciteerd uit gesprek.

[^1]: Eigen test met een realistisch beleidsdocument van 583 woorden (twee A4, met koppen en witregels). Als markdown: 4,3 KB. Dezelfde tekst als kaal Word-bestand (.docx, zonder huisstijl): 37,6 KB (factor 8,8). Als PDF geëxporteerd vanuit Word, zonder embedded fonts of logo: 29,0 KB (factor 6,8). In de praktijk bevatten organisatiedocumenten huisstijl, logo's en embedded fonts, waardoor de factor verder oploopt. Bij PDF/A, het archiveringsformaat dat het Nationaal Archief voorschrijft, is factor 25 tot 100 realistisch. De claim "vijf tot vijftien keer" is daarmee conservatief. Bij langere documenten verschuift het beeld: een kaal .docx-bestand van honderd pagina's is dankzij zip-compressie op schijf juist kleiner dan dezelfde tekst als markdown. Maar opslagruimte is niet de relevante maatstaf. Een .docx-bestand van 47 KB op schijf bevat, eenmaal uitgepakt, 1,2 megabyte aan XML die een machine moet decomprimeren en parsen om bij de tekst te komen. Dezelfde tekst als markdown is 345 KB die direct leesbaar is. De verwerkingslast voor zoeksystemen, archieftools en migratieprocessen is bij .docx daarmee drie tot vier keer zo hoog, ongeacht de bestandsgrootte op schijf.

n.b. De inspiratie voor de titel kwam van Marco Derksen