原作者:Nathan Baschez

主翻译:chatGPT

润润色:Vim

TL;DR:

GPT 席卷全球,除了拥抱之外,也应该停下来思考这个已经不可能退后的风潮未来会怎么样?Nathan Baschez 这篇 LLMs are the new CPUs 提供了非常有启发性的视角:将 LLM,即大语言模型,和电脑发展早期的 CPU 进行了映射对比。除了「这是 AI 领域的 iPhone 时刻」或者「这是图形界面之外我遇到的第二大科技图片」(Bill Gates 语)之外,「LLMs as CPUs」应该是我目前认为最贴切也最有启发的比喻了。而我更希望往前再推进一层:如果 LLM 是新的 Linux 呢?

GPT 席卷全球,除了拥抱之外,也应该停下来思考这个已经不可能退后的风潮未来会怎么样?Nathan Baschez 这篇 LLMs are the new CPUs 提供了非常有启发性的视角:将 LLM,即大语言模型,和电脑发展早期的 CPU 进行了映射对比。除了「这是 AI 领域的 iPhone 时刻」或者「这是图形界面之外我遇到的第二大科技图片」(Bill Gates 语)之外,「LLMs as CPUs」应该是我目前认为最贴切也最有启发的比喻了。而我更希望往前再推进一层:如果 LLM 是新的 Linux 呢?

那时候,计算机足够好,吸引了数百万用户,但其有限的速度和存储空间经常令人头疼。对性能提升的需求是巨大的。但就在新一代更强大的计算机发布后不久,开发人员迅速构建了利用新容量的应用程序,使计算机再次感到缓慢和空间受限,从而刺激对下一代改进的需求。

主要的瓶颈是中央处理器(CPU)。计算机所做的一切都必须经过它,所以如果它超负荷了,一切都会感觉很慢。因此,谁制造了最快的 CPU 就拥有了极其有吸引力的资产,并能为其收取溢价。

英特尔是这个领域的主导者。其兼容设备生态系统、专利库、整合的设计与制造、规模经济、合作伙伴关系和品牌认知(甚至是消费者!)都汇聚在一起,使其在 90 年代成为最大也最赚钱的 CPU 供应商。几乎无法再夸大英特尔的主导地位——在整个时代,它保持了80-90%的市场份额。直到计算平台转向移动,电池效率突然变得极其重要,他们的巨无霸地位才开始解体。

如今,我们正见证一种新型「中央处理器」的出现,它为各种各样的应用程序定义了性能。但是,与执行简单的、确定性的 1 和 0 操作的处理器不同,这些新处理器以自然语言(现在还包括图像)作为输入,执行智能概率推理,并以文本作为输出。

就像 CPU 一样,它们为越来越多的任务提供了核心「大脑」。关键是,它们的性能足够好,吸引了数百万用户,但目前的缺陷如此明显,以至于急需改进。每次推出新模型时,开发人员都会利用新功能并再次将系统推向极限,刺激对下一代改进的需求。

当然,我所谈论的新型中央处理器是 LLM(大型语言模型)。如今,主导 LLM 供应商是 OpenAI。昨天,它发布了最新的GPT-4模型。(注:原文发表于 2023 年 3 月 15 日)

案例研究:英特尔的存储器失败

再一次,我们可以从英特尔的过去中获取有关 OpenAI 未来的见解。英特尔的早年历程是一个具有警示作用的关于商品化的故事。因为英特尔是在 80 年代、90 年代和 21 世纪初 CPU 的主导供应商,这让人很容易忘记它实际上是从 RAM 存储器业务开始的,并且在 20 世纪 70 年代甚至帮助创建了这个市场。它卓越的技术和设计使其在早期几年占领了市场,但随着时间的推移,它在 RAM 市场上竞争力逐渐下降。

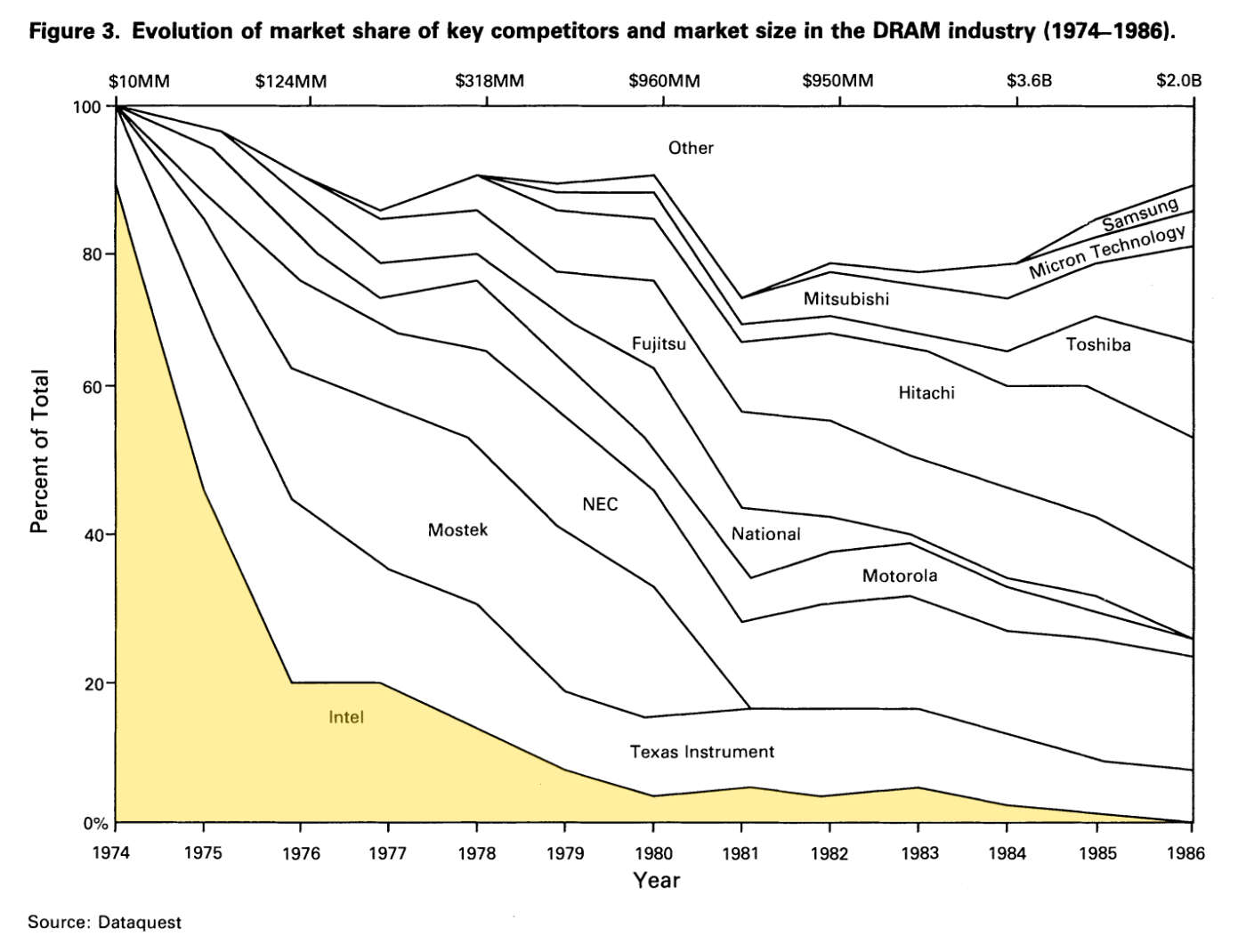

看看英特尔市场份额的急剧下降(见黄色突出显示部分):

发生了什么?竞争基础发生了变化。在存储器行业的早期,最重要的是芯片设计。英特尔凭借最佳工程人才获得了胜利。但随着岁月的推移,制造效率开始变得更加重要。RAM 存储器的基本架构变得更加标准化,许多公司都知道如何制造它,所以赢家变成了那些能够更快、更高效地制造新存储器芯片,产量更高的公司。英特尔的天赋在于芯片设计,而非制造过程。

英特尔很快发现,CPU 业务更适合它们的能力。在这里,制造效率相对较低,而设计和性能更为重要。CPU 是一种更复杂的技术,需要更深入地整合到客户的产品中。一旦你围绕 CPU 架构设计了计算机,切换就变得非常麻烦。英特尔通过向客户展示每年都在推出更强大的芯片,而升级的痛苦很小,从而赢得了市场。客户希望押注在那个能够在最低升级成本下提供最大性能的团队,因此一个生态系统开始围绕英特尔产品发展。

将英特尔的经验教训应用到LLM市场

正如英特尔以艰难的方式了解到的那样,CPU 是一种有差异的产品,而计算机存储器成为了一种商品。那么,在新兴的AI世界中,LLM 将属于哪个类别?

在某些方面,它们很像 CPU。正如我在本文的介绍中所说,从功能角度来看,它们是支持大多数新智能软件功能的中央「大脑」。此外,目前的性能还不够好,而且它是提高整体 AI 产品质量的关键瓶颈,因此开发者和用户对改进有着巨大的需求。

但是,LLM 在关键方面也类似于 RAM。尽管内部复杂性巨大,但 LLM 与其集成的应用程序之间的接口再简单不过了:输入文本,输出文本。(好吧,最新的LLM现在可以接受文本和图像,但接口仍然非常简单,这一点仍然成立。)与CPU不同,将一个 LLM 替换为另一个非常容易。如果您使用像 LangChain 这样的框架,只需更改一行代码。而且,对于许多应用程序来说,使用 LLM 的成本仍然过高,因此在规模上提高效率并降低成本的竞争压力是非常真实的。

当我考虑这些原因时,我不禁得出结论:尽管 LLM 在精神上类似于 CPU,但它们的经济特性更类似于内存业务。如果我是对的,这对OpenAI 来说可能是个坏消息。

关键在于缺乏切换成本。这对应用程序开发者来说是好事,但对 LLM 提供商来说并不是好事。在技术工具中,当切换成本较高时,生态系统往往会围绕它们发展。以 JavaScript 框架为例。如果您使用 ReactJS 编写代码,除非您要构建一个全新的产品,否则您可能不会切换到 Vue。此外,如果您想构建插件或库,通常需要做两倍的工作才能使其与多个框架兼容。这导致了一种由切换成本引发的网络效应,人们只会构建与最受欢迎的框架兼容的库。这反过来导致了「赢家通吃」的状态。

虽然还很早,但我看不到类似的动态会在 LLM 中发生。它们更像是云存储提供商。如果我想将应用程序的图像托管在 Microsoft Azure 上而不是 Amazon S3 上,这将是一个相对简单的更改。目前,LLM 甚至更容易替换,因为它们不保存任何状态或数据。

尽管还没有很多围绕 LLM 构建的开发者工具,但那些确实存在的工具几乎都是「提供商不可知」的——它们是基于「应用程序可能经常更换模型甚至使用多个模型来完成特定任务」的假设。所有这些都是因为「输入文本,输出文本」的接口实在非常简单。

未来接口是否可能变得更复杂,从而增加切换成本呢?这似乎不太可能。当然,构建复杂的接口很容易——难的是让开发者采用它。简单总是更受欢迎。人们采用具有复杂接口的工具(如 Intel 的 x86 指令集或 React 的JavaScript API)的原因是,他们试图完成的任务具有不可化简的复杂性。实际上,很多赢得市场的工具往往因为它们能让复杂的事情变得更简单而获得胜利。我从亲身经历中知道这是 React 获胜的一个重要原因,而关于英特尔的论文也提到这是其成功的重要原因。

我认为可能完全改变这种状态的事是,如果 OpenAI(或其竞争对手之一)决定开源他们的模型。这么做似乎会让他们的力量减弱,但我认为实际上他们会更强大。运行自己的 LLM 实例并对其进行定制要比仅使用简单的 Web API 复杂得多,因此切换成本更高。此外,真正愿意这么做的只有那些具有特定隐私和定制需求的大型组织,所以无论如何,这都是一个有吸引力的客户群体。你可能会损失一些通过运营托管 LLM 服务本可以获得的收入,但你也会开辟与客户服务和咨询相关的新收入来源。

但目前,最好的模型仅通过 API 提供。让我们暂时假设它会一直保持这种状态。OpenAI 是否还有其他方式产生网络效应呢?有人会认为,通过 ChatGPT 与用户的直接联系会有所帮助,因为它为 OpenAI 提供了专有的训练数据,但目前还不清楚这是否会导致 LLM 质量的边际增益。我会密切关注这一点,但我的直觉告诉我,这可能并不那么重要。

对你,这意味着什么

对于开发者来说,现在正是构建由 LLM 驱动的应用程序的好时机。现在可能感觉市场上唯一的选择是 OpenAI,但我怀疑这种状况不会持续太久。OpenAI 是一家重要的公司,但是一旦出现一两个合理的替代品,定价应该会下降。然后,竞争基础很可能会转向规模效率,就像内存业务和云计算一样。

对于 OpenAI 来说,成功将越来越取决于这些因素,开发新的、高质量的模型将不再是唯一重要的事情,就像过去那样。微软 Azure 在这里将是(并且已经是)一个关键合作伙伴,因为它们具有帮助 OpenAI 扩展的资源和专业知识。这不是对未来的预测,而是描述现今的关键因素。这就是为什么新的 ChatGPT API 比之前的 GPT-3 API 便宜 10 倍,以及为什么 OpenAI 和微软的工程师会共同研发定制芯片和基础设施来运行这些模型这件事是极其有意义的。

对于 OpenAI 的竞争对手来说,游戏的主旨还是:迎头赶上。我看到的任何模型在现实世界的性能上都无法接近 GPT-3(更不用说GPT-4了)。在这种情况下,任何关注效率的举措都无关紧要。我的预测是,这种状况可能会持续一两年,然后知识会逐渐传播,出现多个高质量的提供者。

我非常有兴趣看到谷歌会带来什么,据说它在加州山景城的一个柜子里拥有全球最好的模型。也许它会很快发布这些模型?我还关注着 Stability AI,这家公司制造了 Stable Diffusion,传闻正在构建一个开源的 LLM。Anthropic 昨天宣布了 Claude,虽然还处于初期,但非常引人注目——值得关注。

关键是,形势正在发生变化,未来几个月和几年里,观察这一变化将会非常令人兴奋。LLM 不仅仅是另一个 API 服务;它们将成为现代计算的基石,产生类似于 CPU 的影响。

如果你曾经希望能在互联网初始阶段,或者个人电脑产业的早期亲身经历,恭喜!现在你正处于同样重要的时刻。